BERT 语言模型因其对多种语言的广泛预训练而脱颖而出,与其他模型相比,它提供了广泛的语言覆盖范围。 这使得 BERT 对于非英语项目特别有利,因为它提供了跨多种语言的强大上下文表示和语义理解,增强了其在多语言应用中的多功能性。 西风 发自 凹非寺 量子位 | 公众号 QbitAI 时隔6年,一度被认为濒死的“BERT”杀回来了—— 更现代的 ModernBERT 问世,更快、更准、上下文更长,发布. BERT (Bidirectional Encoder Representations from Transformers)是2018年由Google提出的革命性自然语言处理模型,它彻底改变了NLP领域的研究和应用范式。

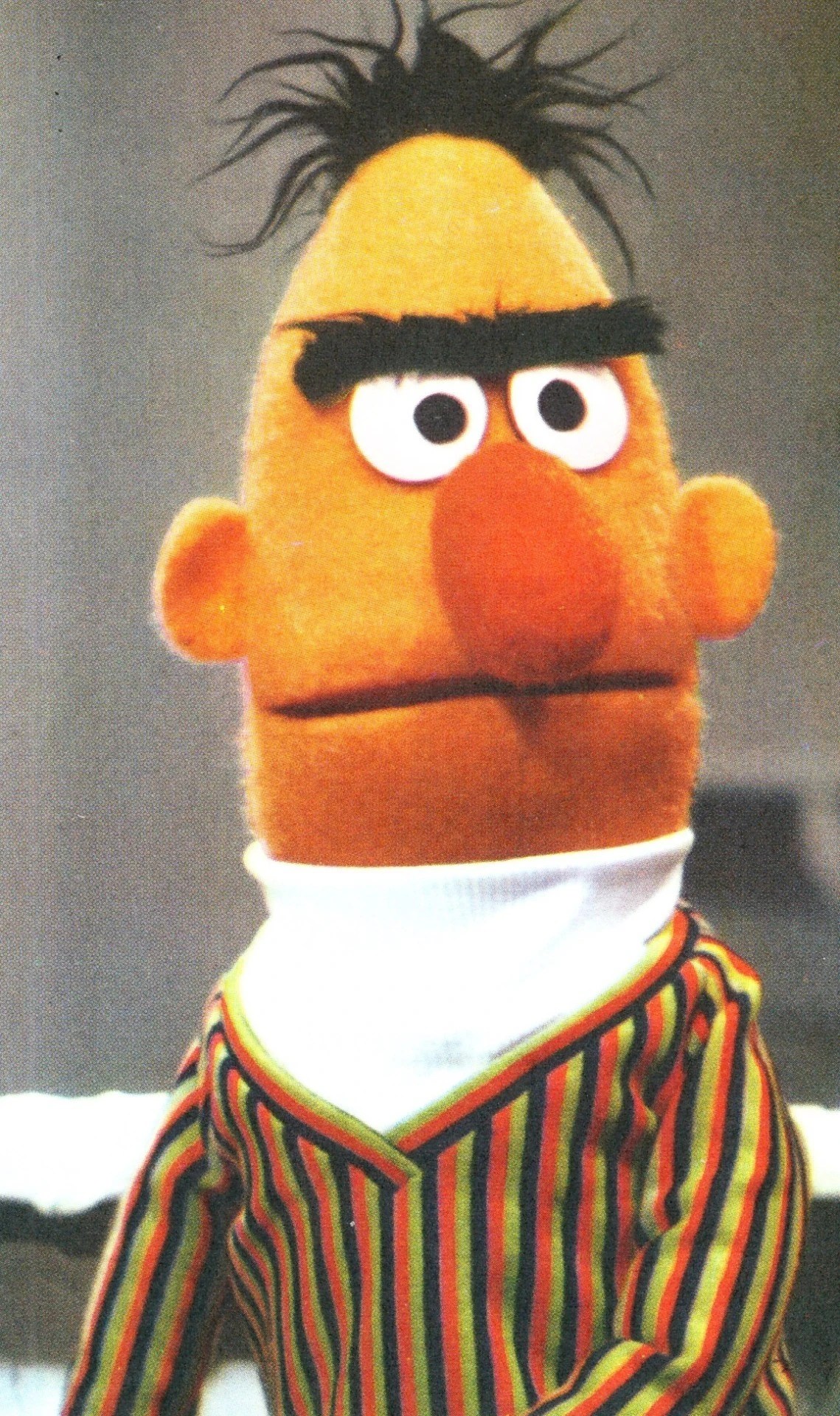

Bert Through the Years | Muppet Wiki | FANDOM powered by Wikia

基於變換器的雙向編碼器表示技術 (英語: Bidirectional Encoder Representations from Transformers, BERT)是用於 自然語言處理 (NLP)的預訓練技術,由 Google 提出。 [1][2] 2018年,雅各布·德夫林和同事創建並發布了BERT。 Google正在利用BERT來更好地理解用戶搜索語句的語義。

BERT 是一个在无标签的文本数据上预训练的双向 transformer,用于预测句子中被掩码的(masked) token,以及预测一个句子是否跟随在另一个句子之后。其主要思想是,在预训练过程中,通过随机掩码一些 token,让模型利用左右上下文的信息预测它们,从而获得更全面深入的理解。此外,BERT 具有很强的.

二、BERT架构深度解析:Transformer的双向革命 BERT的架构设计体现了深度学习在自然语言处理领域的最佳实践。 整个模型由多层Transformer编码器堆叠而成,每一层都包含两个核心组件:多头自注意力机制和前馈神经网络。 2.1 BERT整体架构流程 输入文本序列 精通BERT – 谷歌带来的革新性自然语言处理技术共计9条视频,包括:001 Welcome to the course、001 What is BERT、003 Embedding等,UP主更多精彩视频,请关注UP账号。